Il est difficile d'apprécier l'échelle historique des data centers d'IA. Ils représentent certains des plus grands projets d'infrastructure que l'humanité ait jamais créés.

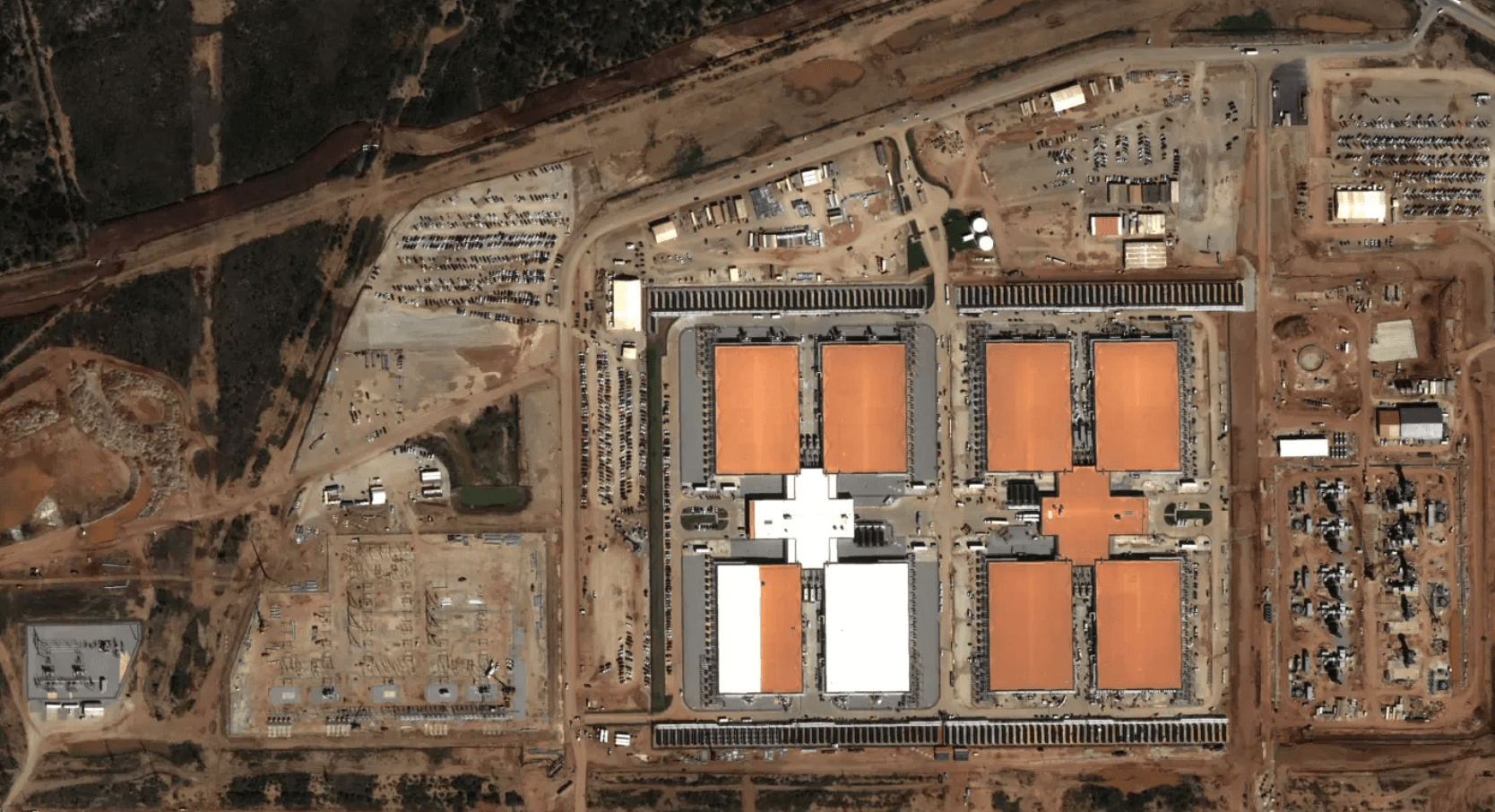

Pour avoir une idée de l'échelle, considérez que le data center Stargate Abilene d'OpenAI aura besoin de :

- Suffisamment d'électricité pour alimenter la population de Seattle

- Plus de 250× la puissance de calcul du superordinateur qui a entraîné GPT-4

- Un terrain plus grand que 450 terrains de football

- 32 milliards de dollars en coûts de construction et d'équipement IT

- Quelques milliers de travailleurs de la construction

- Environ deux ans pour la construction

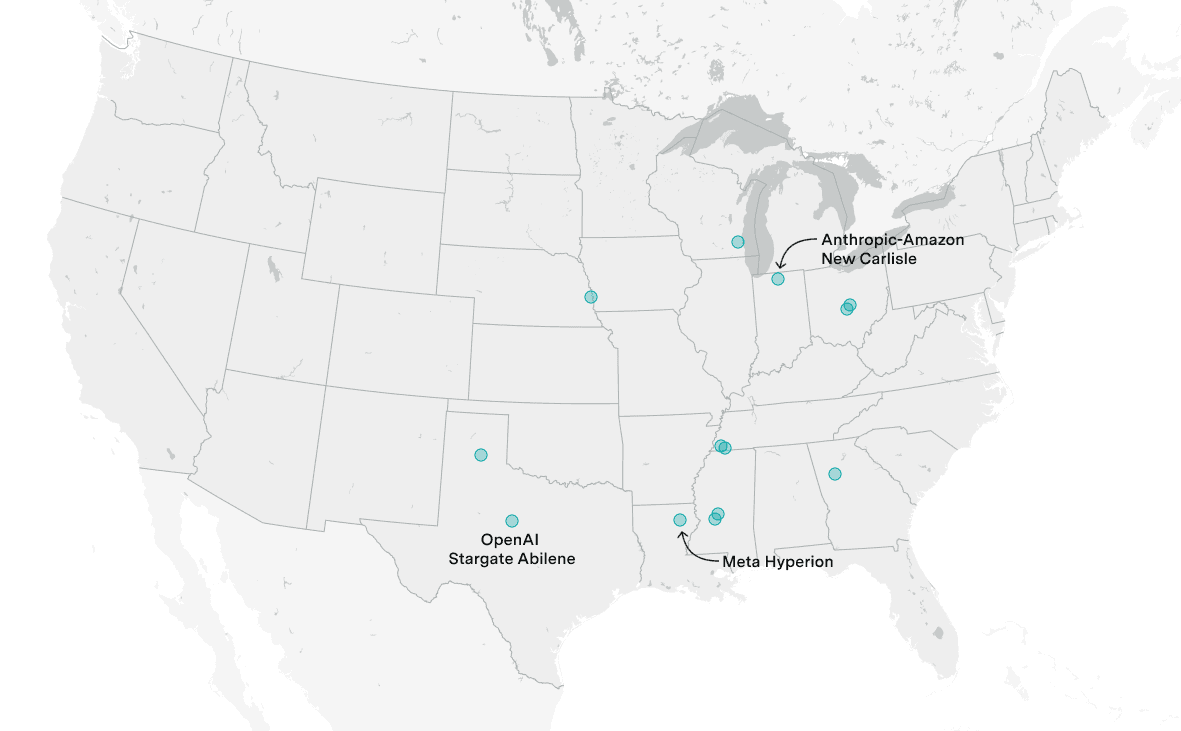

Et ce n'est qu'une petite partie du tableau. Les entreprises construisent actuellement de nombreux autres data centers comme Stargate Abilene. D'ici fin 2027, les data centers d'IA pourraient collectivement voir des centaines de milliards d'investissements — rivalisant avec le programme Apollo et le projet Manhattan.

Énergie – l'élément le plus important à connaître sur un data center d'IA

L'énergie détermine où les data centers d'IA sont construits

Un data center d'IA n'est qu'un groupe de bâtiments remplis d'ordinateurs pour entraîner et exécuter des systèmes d'IA. Ce qui les rend uniques, c'est qu'ils doivent être énormes pour aider à soutenir la demande massive de l'IA en ressources de calcul — souvent appelé simplement « compute ». Si vous pouviez d'une manière ou d'une autre entraîner Grok 4 de xAI sur un iPad Pro 2024, il vous faudrait plusieurs centaines de milliers d'années pour terminer. Et le compute utilisé pour entraîner les modèles d'IA frontière croît d'environ 5× par an.

Avec autant de compute, les data centers d'IA ont besoin de beaucoup d'énergie. Cela signifie que la plupart des data centers d'IA seront construits dans la poignée de pays capables de fournir cette énergie — au moins au cours des prochaines années.

De combien d'énergie parlons-nous vraiment ? Aux États-Unis, les data centers d'IA auront collectivement besoin d'environ 20 à 30 gigawatts (GW) d'énergie d'ici fin 2027. Pour mettre cela en perspective, 30 GW représente environ 5% de la capacité moyenne actuelle de production d'énergie des États-Unis et 2,5% de celle de la Chine — des fractions importantes mais gérables de ces grands réseaux.

D'où vient l'énergie

La plupart de l'énergie provient encore du réseau électrique public, qui est un mélange de sources d'énergie. Aux États-Unis, environ 60% de l'électricité provient de combustibles fossiles (principalement du gaz naturel), 18% de l'énergie nucléaire, et le reste des énergies renouvelables.

Certaines entreprises explorent également des contrats d'achat d'énergie directe avec des fournisseurs d'énergie renouvelable ou nucléaire. Par exemple, Amazon a récemment signé un accord pour acheter jusqu'à 960 MW d'énergie nucléaire en Pennsylvanie.

Le gaz naturel domine

Le gaz naturel reste la source d'énergie la plus commune pour les data centers d'IA aux États-Unis. C'est parce qu'il est abondant, relativement bon marché, et peut fournir une alimentation stable et fiable. Les centrales électriques au gaz peuvent également être construites relativement rapidement comparées aux centrales nucléaires ou aux grands barrages hydroélectriques.

Cependant, le gaz naturel est un combustible fossile et contribue aux émissions de gaz à effet de serre. Cela crée une tension entre le besoin d'énergie fiable pour l'IA et les objectifs de réduction des émissions de carbone.

L'énergie renouvelable se développe mais a des limites

L'énergie solaire et éolienne deviennent de plus en plus compétitives en termes de coûts. Cependant, elles sont intermittentes - le soleil ne brille pas toujours et le vent ne souffle pas toujours. Les data centers d'IA nécessitent une alimentation électrique 24h/24 et 7j/7, ce qui rend les énergies renouvelables seules inadaptées sans stockage par batterie à grande échelle.

Le stockage par batterie s'améliore mais reste coûteux et a une capacité limitée. Pour l'instant, les énergies renouvelables peuvent compléter mais pas remplacer entièrement les sources d'énergie de base comme le gaz naturel et l'énergie nucléaire.

L'énergie nucléaire offre une puissance de base propre

L'énergie nucléaire peut fournir une alimentation constante et fiable avec zéro émission de carbone. C'est pourquoi certaines entreprises comme Amazon et Microsoft explorent des partenariats avec des fournisseurs d'énergie nucléaire.

Cependant, l'énergie nucléaire a ses propres défis. Les centrales nucléaires sont coûteuses et prennent de nombreuses années à construire. Aux États-Unis, de nouvelles centrales nucléaires n'ont pas été construites depuis des décennies en raison de préoccupations de sécurité et de coûts élevés.

Ce qui rend les data centers d'IA spéciaux

Les data centers d'IA diffèrent des data centers traditionnels de plusieurs façons importantes. La plus importante est leur densité de puissance exceptionnellement élevée.

Les data centers d'IA ont des densités énergétiques exceptionnellement élevées

Un data center traditionnel pourrait avoir une densité de puissance de 5-10 kilowatts (kW) par rack de serveurs. Un data center d'IA moderne peut avoir des densités de puissance de 100 kW ou plus par rack - 10 à 20 fois plus élevées.

Cette concentration extrême de puissance dans un espace si petit crée des défis uniques. La distribution de l'électricité, le refroidissement, et la gestion de l'infrastructure deviennent beaucoup plus complexes.

Les densités énergétiques élevées nécessitent des systèmes de refroidissement uniques

Toute l'électricité consommée par les serveurs d'IA est finalement convertie en chaleur. Avec des densités de puissance de 100+ kW par rack, les méthodes de refroidissement traditionnelles par air ne suffisent plus.

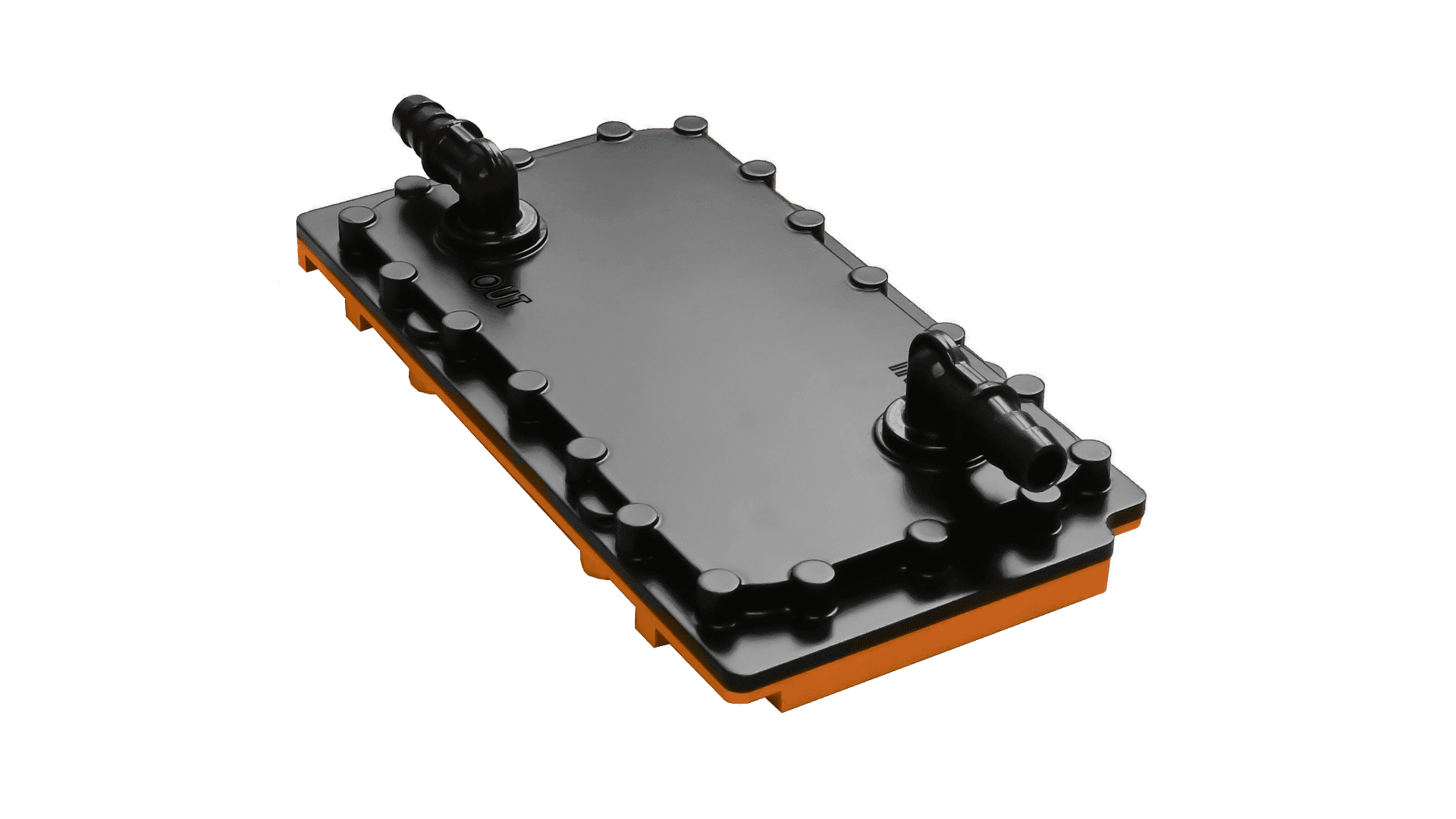

Le refroidissement liquide devient standard

La plupart des data centers d'IA modernes utilisent le refroidissement liquide direct. Cela implique de pomper de l'eau ou d'autres liquides directement vers des plaques de refroidissement attachées aux processeurs GPU. Le liquide absorbe la chaleur et est ensuite pompé hors du serveur pour être refroidi.

Le refroidissement liquide est beaucoup plus efficace que le refroidissement par air. Il peut transférer bien plus de chaleur et permet des densités de puissance plus élevées. Cependant, il est aussi plus complexe et coûteux à installer et maintenir.

Refroidisseurs et tours de refroidissement

Une fois que le liquide de refroidissement absorbe la chaleur des serveurs, il doit être refroidi avant de pouvoir être réutilisé. C'est là qu'interviennent les refroidisseurs et les tours de refroidissement.

Les refroidisseurs utilisent des compresseurs pour transférer la chaleur du liquide de refroidissement à l'eau. Cette eau circule ensuite vers les tours de refroidissement, où elle est refroidie par évaporation. Les grandes installations peuvent avoir des dizaines de tours de refroidissement massives, chacune de plusieurs étages de haut.

La consommation d'eau est une préoccupation majeure

Le refroidissement évaporatif consomme beaucoup d'eau. Un data center de 1 GW utilisant le refroidissement évaporatif pourrait consommer plusieurs millions de litres d'eau par jour - suffisamment pour desservir une petite ville.

Cela soulève des préoccupations, en particulier dans les régions déjà confrontées à la pénurie d'eau. Certaines installations explorent des alternatives comme le refroidissement par air sec (qui fonctionne mieux dans les climats arides et frais) ou des systèmes en circuit fermé qui recyclent l'eau et réduisent la consommation.

Que signifie tout cela pour les progrès et les politiques en IA ?

L'infrastructure physique devient un goulot d'étranglement majeur

Historiquement, les progrès de l'IA ont été principalement limités par les algorithmes, les données et la puissance de calcul. Maintenant, l'infrastructure physique - l'énergie, le refroidissement et l'espace - devient un facteur limitant majeur.

Construire un data center de 5 GW comme Stargate Abilene n'est pas seulement une question d'acheter plus de GPU. Cela nécessite de sécuriser l'approvisionnement énergétique, de construire l'infrastructure de refroidissement, d'obtenir les permis et approbations réglementaires, et de coordonner avec les services publics locaux. Tout cela prend du temps et des milliards de dollars d'investissement.

Seuls quelques pays peuvent soutenir des data centers d'IA à grande échelle

La construction de data centers d'IA multi-gigawatt nécessite non seulement d'énormes quantités d'énergie, mais aussi une infrastructure électrique stable, un environnement réglementaire favorable et un capital important.

Cela signifie que les data centers d'IA de pointe seront principalement concentrés dans quelques pays - principalement les États-Unis et la Chine, avec peut-être quelques installations en Europe et au Moyen-Orient. Les pays avec des réseaux électriques moins développés ou des environnements réglementaires plus restrictifs auront du mal à rivaliser.

L'impact climatique global de l'IA n'est pas très important (pour l'instant)

Malgré les chiffres impressionnants, l'impact climatique actuel des data centers d'IA est relativement modeste à l'échelle mondiale. Même 30 GW de data centers d'IA représenteraient moins de 1% de la consommation mondiale d'électricité.

Cependant, cela pourrait changer rapidement. Si la demande en compute d'IA continue de croître de 5× par an, la consommation d'énergie pourrait devenir une fraction bien plus importante de la consommation mondiale d'électricité d'ici quelques années.

De plus, si cette énergie provient principalement de combustibles fossiles, elle pourrait contribuer de manière significative aux émissions de gaz à effet de serre. C'est pourquoi de nombreuses entreprises investissent dans l'approvisionnement en énergies renouvelables et nucléaires pour leurs data centers.

Les entreprises n'auront probablement pas besoin de décentraliser la formation en IA au cours des deux prochaines années

Certains ont suggéré que les contraintes énergétiques pourraient forcer les entreprises à décentraliser l'entraînement de l'IA - en divisant les calculs entre plusieurs data centers dans différentes régions ou même différents pays.

Cependant, la décentralisation introduit des défis importants. L'entraînement de modèles d'IA nécessite une communication constante et rapide entre les serveurs. Distribuer cet entraînement sur de longues distances introduit de la latence et réduit l'efficacité.

Pour les deux prochaines années au moins, il sera probablement plus efficace de construire de plus grands data centers centralisés plutôt que de décentraliser l'entraînement. Cependant, à plus long terme, à mesure que les exigences énergétiques continuent de croître, la décentralisation pourrait devenir nécessaire.

Les data centers d'IA à l'échelle du gigawatt sont difficiles à sécuriser

Les data centers d'IA contiennent du matériel valant des milliards de dollars et entraînent des modèles d'IA qui représentent des investissements encore plus importants en recherche et développement. Ils sont également des cibles attractives pour le vol de propriété intellectuelle, le sabotage ou même les attaques militaires.

Cependant, sécuriser des installations aussi massives est un défi. Elles couvrent de vastes zones - Stargate Abilene s'étend sur plus de 800 hectares. Elles nécessitent également des milliers d'employés pour l'exploitation et la maintenance, créant de nombreux vecteurs d'attaque potentiels.

Les entreprises investissent massivement dans la sécurité physique et cybernétique. Cela comprend des clôtures périmétriques, des gardes, une surveillance biométrique, une surveillance vidéo constante et des mesures de cybersécurité avancées.

Cependant, à mesure que les data centers deviennent plus grands et plus précieux, ils deviennent également des cibles plus attractives. La sécurité restera un défi continu et évolutif.

Conclusion

Les data centers d'IA représentent l'un des plus grands défis d'infrastructure de notre époque. Leur construction nécessite des quantités sans précédent d'énergie, d'eau, de capital et de coordination entre les secteurs public et privé.

Les principaux points à retenir sont :

- Les data centers d'IA nécessiteront 20-30 GW d'énergie aux États-Unis d'ici fin 2027

- La plupart de l'énergie provient actuellement du gaz naturel, mais les énergies renouvelables et nucléaires se développent

- Les densités de puissance extrêmes (100+ kW par rack) nécessitent un refroidissement liquide sophistiqué

- L'infrastructure physique devient un facteur limitant majeur pour les progrès de l'IA

- Seuls quelques pays peuvent soutenir des data centers d'IA à grande échelle

- L'impact climatique est actuellement modeste mais pourrait croître rapidement

- La sécurisation de ces installations massives pose des défis uniques

L'essentiel

Les data centers d'IA de prochaine génération représentent certains des plus grands projets d'infrastructure jamais entrepris. Leur développement réussi est essentiel pour maintenir les progrès rapides de l'IA, mais soulève d'importantes questions concernant la consommation d'énergie, l'utilisation de l'eau, l'impact environnemental et la sécurité. Comprendre ces défis est crucial pour façonner des politiques efficaces et durables pour l'avenir de l'IA.